Suivi de cible et pointage laser en temps réel via TPU Coral USB : un projet de computer vision embarquée

Dans le cadre de son stage chez Selva Systems, Adrien Chevrier, étudiant en 4ᵉ année de la spécialité Électronique et Télécommunications (ELT) à l’ENSIL/ENSCI, a mené un projet de vision par ordinateur embarquée. L’objectif principal était de démontrer la faisabilité d’un suivi et d’un pointage laser de cible à l’aide d’une diode laser, en temps réel, avec l’ensemble du traitement réalisé localement sur un système embarqué léger.

Bertrand Selva

7/9/20253 min read

Le principe de fonctionnement est simple : une caméra capture l’image de la scène, un modèle de détection (YoLo) identifie la position de la cible, et deux miroirs acryliques orientés par des moteurs pas à pas dévient le faisceau laser pour pointer précisément la cible détectée. La faible inertie du dispositif permet une commande en boucle ouverte, sans capteurs de retour, facilitant ainsi la commande (on fait l’hypothèse que le couple des moteurs est grand devant l’inertie des miroirs : à chaque instant la consigne est respectée et il suffit de « compter » les pulses envoyés au moteur pour connaitre la position du pointage laser). Le système parvient à traiter les images, détecter la cible, calculer la commande des moteurs et orienter le laser suffisamment vite pour assurer un suivi continu en temps réel.

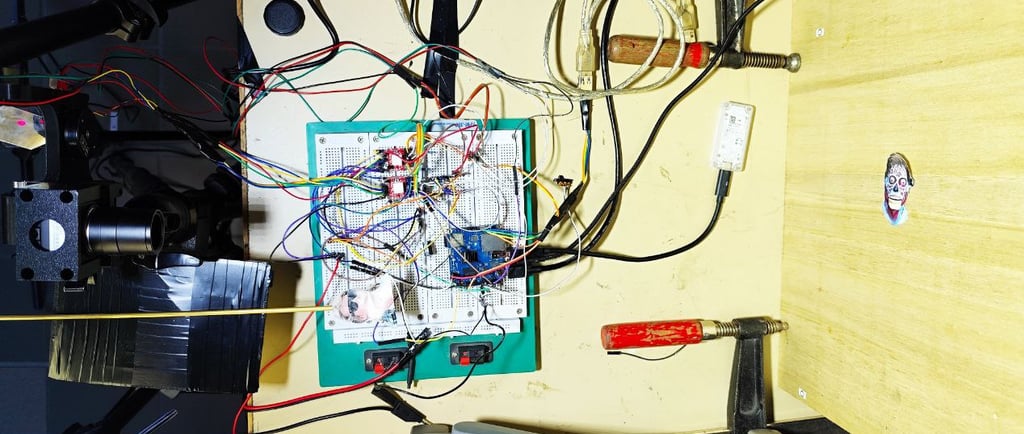

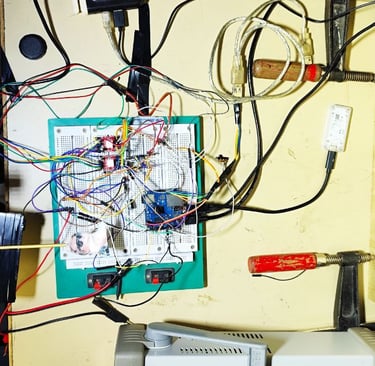

Le cœur du projet repose sur l’entraînement et le déploiement d’un modèle YOLOv8 Nano, choisi pour sa légèreté et son efficacité en contexte embarqué. L'acquisition du jeu de données et l'entraînement du modèle ont été réalisés par Adrien Chevrier. Les cibles sont issues du film They Live de John Carpenter, avec 1500 images annotées représentant des aliens, le personnage de John Nada et des fonds vides. Après l’entraînement, le modèle a été converti pour une exécution optimisée sur TPU Coral USB (étape de quantification en UINT8), un accélérateur d’inférence USB. Il a été utilisé sur un Orange Pi Zero 3 qui est également en charge de l’acquisition des images via une caméra USB (320x240 à 120 fps) ainsi que de la génération des trains d’impulsion pour les moteurs avec ces canaux PWM.

L’ensemble du pipeline a ainsi été mis en place, depuis l’acquisition d’images jusqu’à la commande des actionneurs. Ce projet valide l’intégration rapide d’un système de vision embarquée sur TPU, combinant acquisition, traitement, détection et actionnement.

La vidéo suivante illustre concrètement le fonctionnement du système :

Le système atteint des performances très correctes, avec une cadence de traitement de 5 images par seconde sur CPU seulement, portée à 18 images par seconde grâce au TPU Coral USB. Le suivi laser de lq cible démontre la solidité du pipeline mis en place.

Une consommation minimale, preuve concrète d’une IA frugale embarquée

Un aspect essentiel du projet réside dans la très faible consommation énergétique de l’ensemble du système. Orange Pi Zero 3 et TPU Coral USB inclus, la consommation totale plafonne à environ 5 watts en fonctionnement. Ce chiffre montre qu’il est tout à fait possible de déployer des systèmes de vision par ordinateur performants sans nécessiter de ressources énergétiques importantes.

Le TPU Coral USB joue ici un rôle décisif. Il affiche une efficacité énergétique importante d’environ 2 TOPS par watt. Cette efficacité place ce TPU parmi les meilleures options actuelles pour les systèmes d’IA embarquée avec des applications de computer vision, en particulier dans des contextes où la sobriété énergétique est un impératif (il existe en effet beaucoup d’offres concurrentes mais plus puissantes et plus consommatrices).

Ce projet démontre que l’avenir de l’IA frugale passe par ce type d’accélérateurs spécialisés. En permettant de traiter localement des flux vidéo en temps réel tout en limitant drastiquement la consommation, ces solutions ouvrent la voie à des systèmes embarqués de computer vision autonomes et déployables sans dépendance au cloud.

Perspectives d'utilisation

Au-delà de ce projet spécifique, les compétences développées et la méthodologie employée ouvrent des perspectives concrètes pour d’autres applications, notamment dans le domaine du Structural Health Monitoring (SHM). Des usages potentiels sont envisagés pour l’identification de pathologies à partir d’images. La structure du pipeline et l’expérience acquise sur ce démonstrateur sont directement transposables à ce genre d’application.

Ce projet pourrait également servir de base pour la création de travaux pratiques (TP) en computer vision embarquée, pour le volet académique de mon activité. En remplaçant les actionneurs actuels par des miroirs galvanométriques issus d’imprimantes 3D résine, comme ceux disponibles ici, il serait possible d’obtenir un suivi beaucoup plus rapide et précis (les actionneurs dans la version actuelle ne sont pas du tout à la hauteur de la qualité des résultats d’inférence et limitent fortement les performances du démonstrateur), tout en conservant une approche pédagogique concrète, mêlant vision par ordinateur, commande et systèmes embarqués.

Innovation

Systèmes embarqués, intelligence artificielle, deep learning, solutions sur mesure, efficacité, innovation, sécurité, fiabilité.

Contact

© 2025. All rights reserved.

© 2025. Tous droits réservés.